Monocular Depth Estimation 논문 정리

1. Structured Attention Guided Convolutional Neural Fields for Monocular Depth Estimation [CVPR 2018]

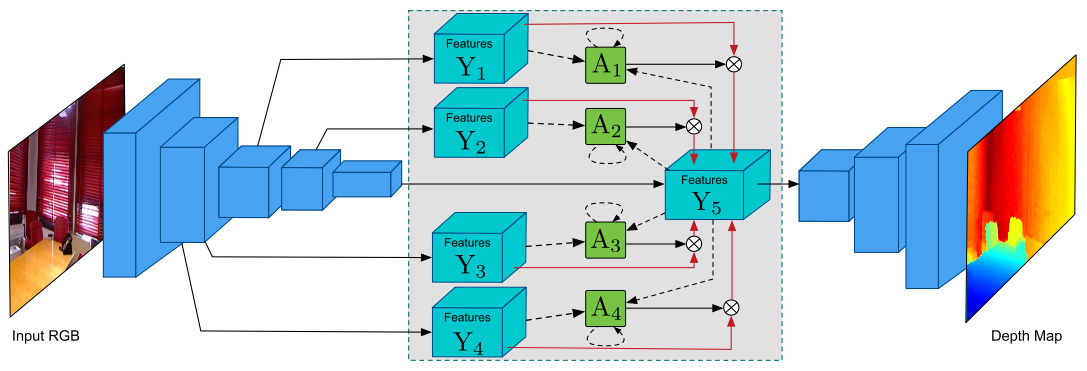

Conditional Random Field (CRF)을 모델에 적용한다. 또한 multi-scale feature들을 학습하기 위해 attention mechanism을 사용한다. 데이터셋은 NYU Depth V2와 KITTI 데이터셋에서 평가된다.

Contribution은 다음과 같이 요약된다.

-

Front-end CNN과 multi-scale CRF을 통합하여 모델을 end-to-end로 학습할 수 있다.

-

Attention mechanism을 통해 multiple-scale feature로부터 structured information를 잘 통합할 수 있다.

-

NYU Depth V2와 KITTI 데이터셋에서 SOTA를 달성한다.

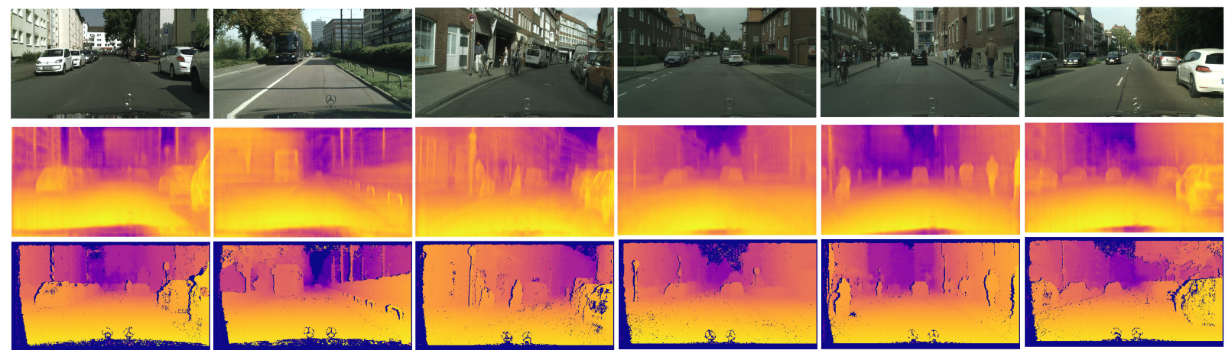

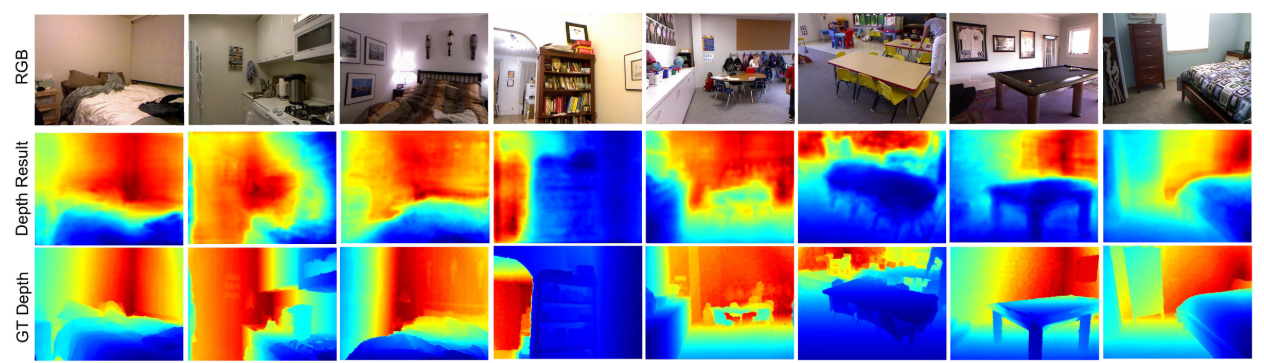

결과는 다음과 같다.

1) NYU Depth V2

2) KITTI

github.com/danxuhk/StructuredAttentionDepthEstimation

danxuhk/StructuredAttentionDepthEstimation

Structured Attention Guided Convolutional Neural Fields for Monocular Depth Estimation in CVPR 2018 (Spotlight) - danxuhk/StructuredAttentionDepthEstimation

github.com

2. PAD-Net: Multi-Tasks Guided Prediction-and-Distillation Network for Simultaneous Depth Estimation and Scene Parsing [CVPR 2018]

논문은 depth estimation을 보조하기 위해 multi-task learning을 적용한다. 이를 통해 모델은 좀 더 풍부한 multi-modal information을 제공할 수 있다. 논문은 모델 중간에 monocular depth prediction, surface normal estimation, semantic segmentation, contour detection의 총 4가지 multi-task learning을 수행한다.

Contribution은 다음과 같이 요약된다.

-

PAD-Net을 제안하여 모델이 풍부한 multi-modal 데이터를 제공하는 것을 목표로 한다.

-

3가지 종류의 multi-modal distillation module을 고안한다.

-

NYUD-v2 데이터셋에서 SOTA를, Cityscapes 데이터셋에서 경쟁력있는 성과를 얻음

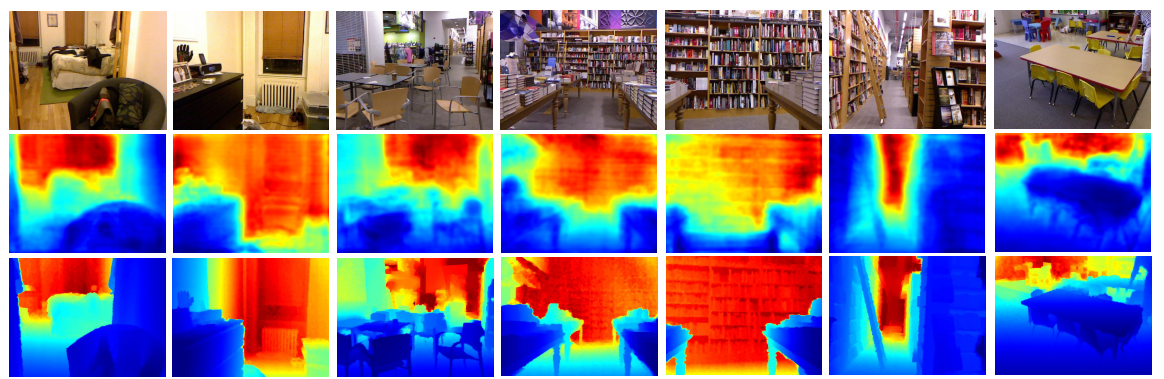

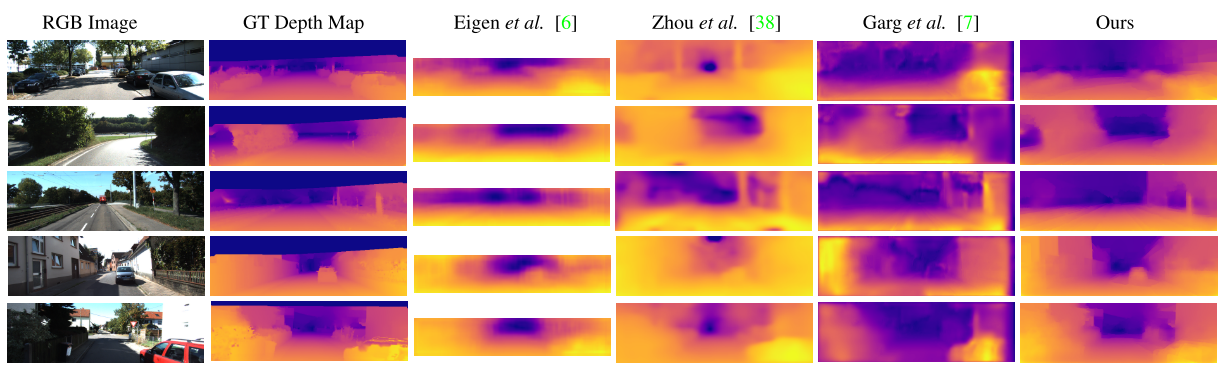

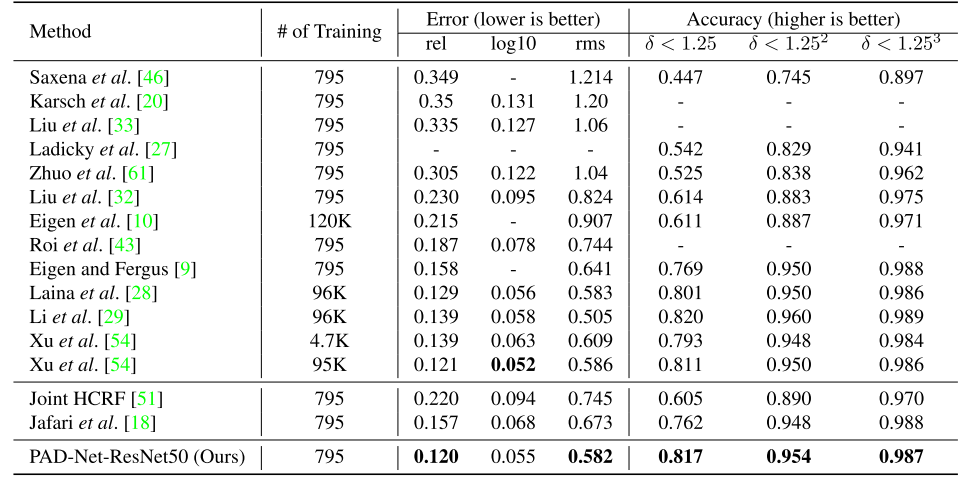

결과는 다음과 같다.

1) NYUD-V2

2) Cityscapes