-

Bias-Variance Trade Off머신러닝 기초 2019. 9. 29. 00:05반응형

자세한 설명은 뒤에서 다루겠지만 error는 noise, bias, variance 3가지 성분으로 구성된다. bias는 참 값들과 추정 값들의 차이(또는 평균 간의 거리)를 의미하고, variance는 추정 값들의 흩어진 정도를 의미한다. 아래 그림을 참고하자.

예를 들어 (b) 모델은 추정 값들을 평균한 값은 참 값과 비슷한데(bias가 작은데), 추정 값들의 variance가 커서 loss가 큰 모델이다. (c)는 bias가 크고, variance가 작은 모델이고, (d)는 둘 다 큰 모델이다.

각각의 성분이 error에 미치는 영향은 아래와 같다.

1. Noise

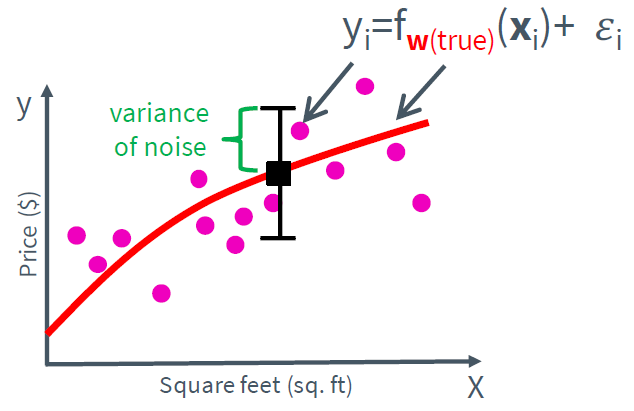

noise는 우리가 학습시키고자 하는 모델과 독립적이기 때문에 학습을 통해 최소화하는 것이 불가능하다. 따라서 noise는 데이터가 가지는 본질적인 한계치이기 때문에 irreducible error라고도 불린다.

2. Bias

bias는 데이터 내에 있는 모든 정보를 고려하지 않음으로 인해, 지속적으로 잘못된 것들을 학습하는 경향을 가진다.(underfitting) 따라서 위와 같이 모델의 complexity가 작다면 bias가 커진다.

3. Variance

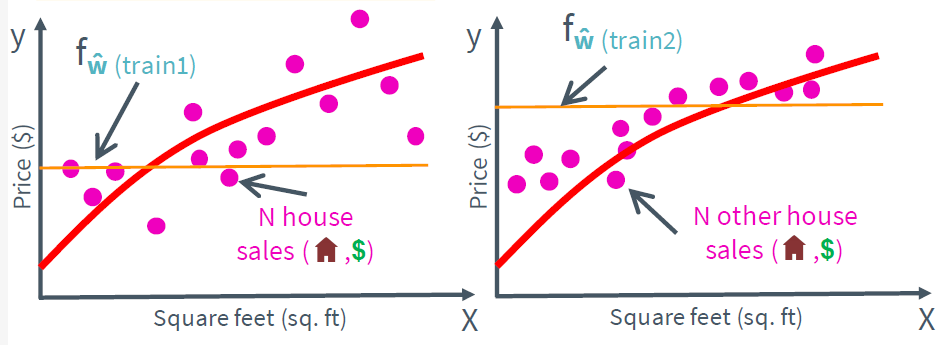

Variance는 highly flexible models에 데이터를 fitting 시킴으로써, 실제 현상과 관계없는 random 한 것들까지 학습하는 알고리즘의 경향을 가진다. 따라서 아래와 같이 모델의 complexity가 크다면 variance가 커진다.

이상적인 모델은 데이터의 규칙성을 잘 잡아내어 정확하면서도 다른 데이터가 들어왔을 때도 잘 일반화할 수 있는 모델일 것이다. 하지만 위와 같은 특징 때문에 bias와 variance는 동시에 작아지지 않으며 trade-off 관계에 놓인다. 그래프로 표현하면 아래와 같다.

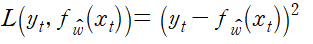

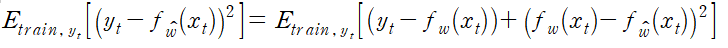

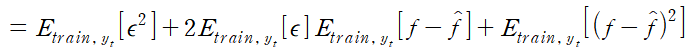

이제 앞서 설명했듯이 prediction error가 bias, variance, noise 항으로 이루어진 이유를 설명하겠다. 먼저 특정한 xt에 대해 다음이 성립한다.

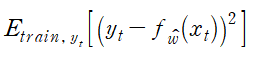

따라서 expected prediction error는

이다. 따라서 정리하면 (단 w는 w(true)를 의미한다.)

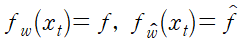

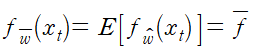

이다. 식을 간단히 하기 위해

라고 하면

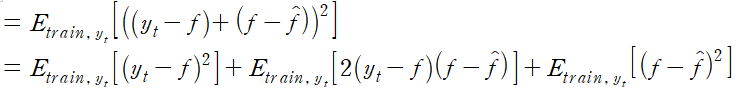

이고

임을 이용하면 다음과 같이 정리된다.

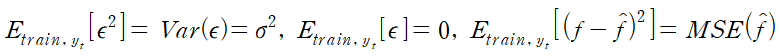

또한

이므로 정리하면 (MSE는 Mean Squard Error이다.)

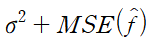

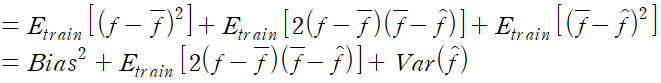

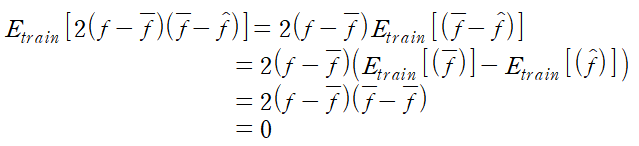

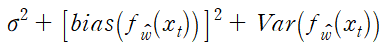

이다. 이제 MSE 항을 정리해보자.

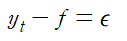

에서

라고 하면

이때

이므로 xt의 expected prediction error는

이다.

반응형'머신러닝 기초' 카테고리의 다른 글

Ridge Regression #2 (0) 2019.10.05 Ridge Regression #1 (0) 2019.10.03 Assessing Performance (0) 2019.09.28 Numerical vs. analytic gradients (0) 2019.09.23 Linear regression (0) 2019.09.22